深度神經網絡壓縮與加速技術 賦能高效網絡服務的新引擎

隨著人工智能技術的快速發展,深度神經網絡(DNN)在圖像識別、自然語言處理、語音識別等領域取得了顯著成就。日益復雜的網絡模型帶來了巨大的計算和存儲開銷,嚴重限制了其在資源受限環境下的部署。深度神經網絡壓縮與加速技術應運而生,成為推動高效網絡服務落地的關鍵技術。

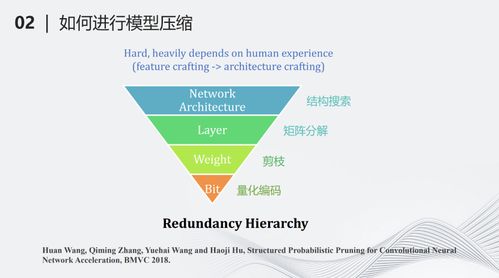

一、深度神經網絡壓縮技術

深度神經網絡壓縮主要通過減少模型的參數量和計算量,同時盡量保持模型的準確性。主要壓縮方法包括:

- 權重剪枝:通過移除冗余或重要性較低的連接,減少網絡參數。例如,迭代式剪枝可逐步識別并移除對精度影響最小的權重。

- 量化:將浮點權重和激活值轉換為低精度表示,如8位整數。量化不僅能減小模型存儲空間,還能加速推理過程。

- 知識蒸餾:利用預訓練的大模型(教師模型)指導小模型(學生模型)訓練,使小模型學習到大模型的泛化能力。

- 低秩分解:將全連接層或卷積層的權重矩陣分解為多個小矩陣的乘積,從而降低計算復雜度。

二、深度神經網絡加速技術

網絡加速技術側重于優化計算過程,提升推理速度:

- 硬件加速:利用GPU、TPU、FPGA等專用硬件并行計算能力,大幅提升神經網絡前向推理速度。

- 網絡結構優化:設計輕量級網絡結構,如MobileNet、ShuffleNet等,通過深度可分離卷積等技術減少計算量。

- 編譯器優化:通過圖優化、算子融合等技術,減少內存訪問和計算開銷,如TVM、TensorRT等推理框架。

- 動態推理:根據輸入樣本的復雜度動態調整計算路徑,簡單樣本使用輕量級子網絡,復雜樣本使用完整網絡。

三、網絡服務中的應用價值

壓縮與加速技術為網絡服務帶來顯著優勢:

- 邊緣計算部署:使復雜神經網絡能夠在手機、嵌入式設備等資源受限環境中高效運行,實現本地化智能服務。

- 實時服務響應:大幅降低推理延遲,滿足自動駕駛、實時翻譯等對響應時間敏感的應用需求。

- 成本優化:減少服務器資源消耗,降低云計算成本,使大規模AI服務部署更加經濟可行。

- 能耗降低:輕量化模型減少計算能耗,符合綠色計算發展趨勢。

四、未來發展趨勢

未來深度神經網絡壓縮與加速技術將向更智能、更自動化的方向發展:

- 自動化壓縮:基于強化學習或進化算法的自動網絡壓縮,無需人工設計壓縮策略。

- 硬件算法協同設計:針對特定硬件架構優化網絡結構,實現算法與硬件的最佳匹配。

- 動態自適應壓縮:根據設備狀態和環境需求動態調整模型復雜度,實現資源與性能的最佳平衡。

- 跨模態壓縮:面向多模態應用的統一壓縮框架,支持視覺、語言、語音等多種任務的聯合優化。

深度神經網絡壓縮與加速技術正在重塑人工智能服務的部署范式,為各行各業提供更高效、更經濟的智能解決方案。隨著技術的不斷成熟,我們有理由相信,壓縮后的輕量化神經網絡將在更多場景中發揮關鍵作用,推動人工智能技術真正實現普惠化應用。

如若轉載,請注明出處:http://www.tianshu2.com/product/4.html

更新時間:2026-01-17 09:25:54